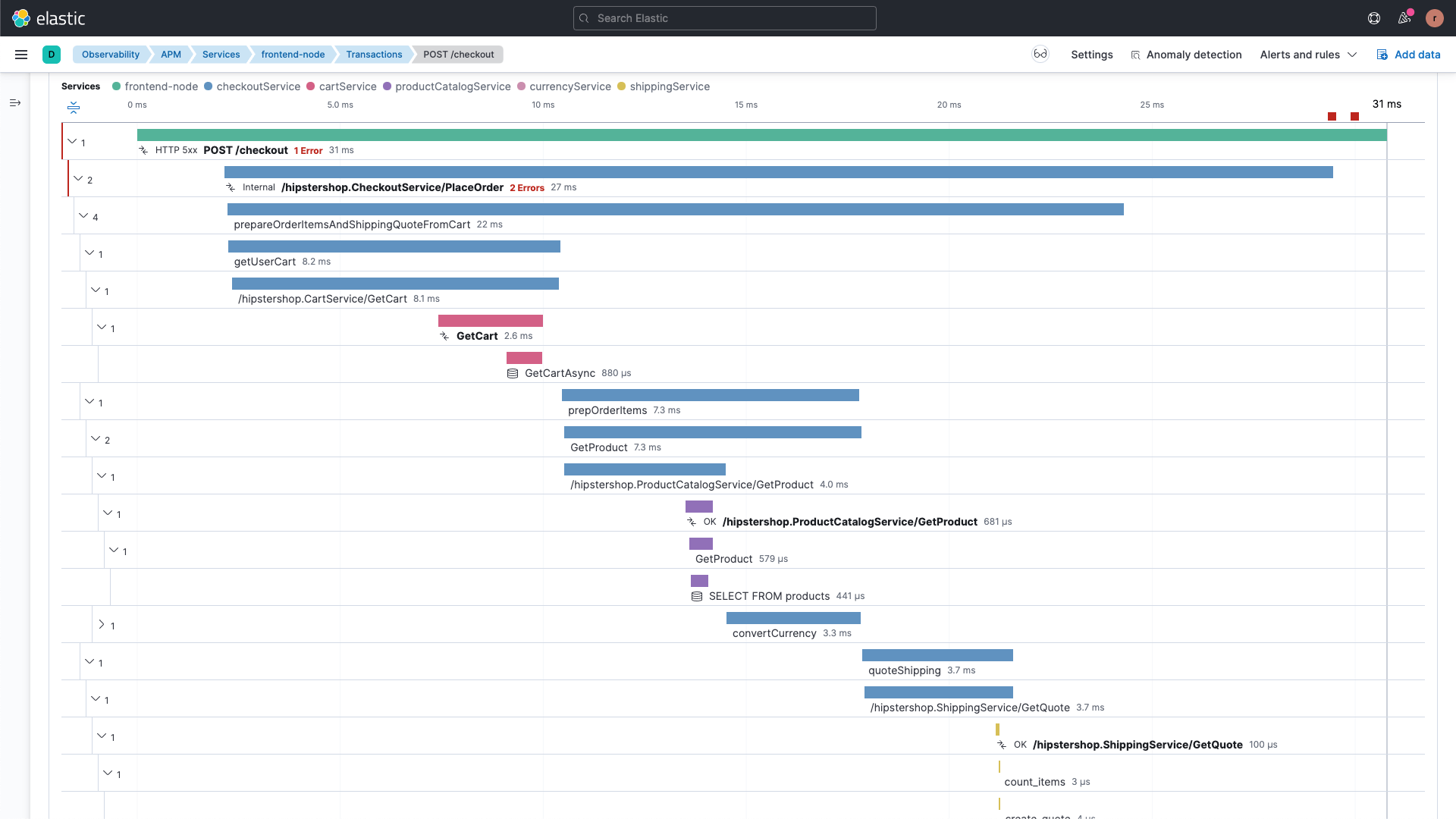

通过端到端分布式跟踪提高代码质量

捕获并分析跨越微服务、无服务器组件和 LLM 的分布式事务,包括支持 AWS Lambda 和OpenAI,以及对 Java、.NET、PHP、Python、Go 等流行语言进行自动检测。通过丰富的事务元数据和标签,调查从客户端到应用程序、云服务和 LLM 服务的每一层,以加快分析速度。使用客户数据和部署标记对事务进行注释,最大程度地减少中断并优化客户体验。

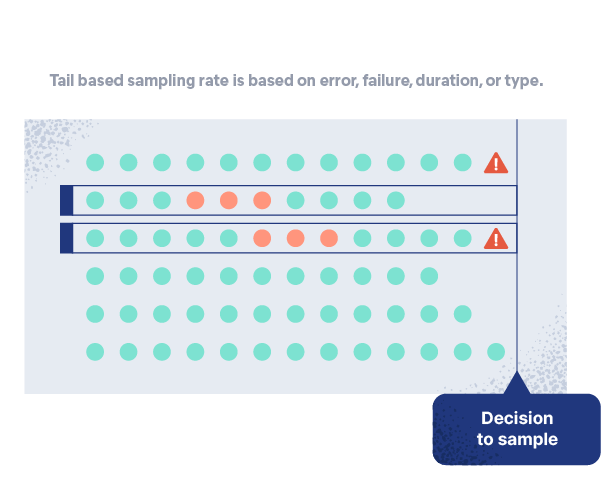

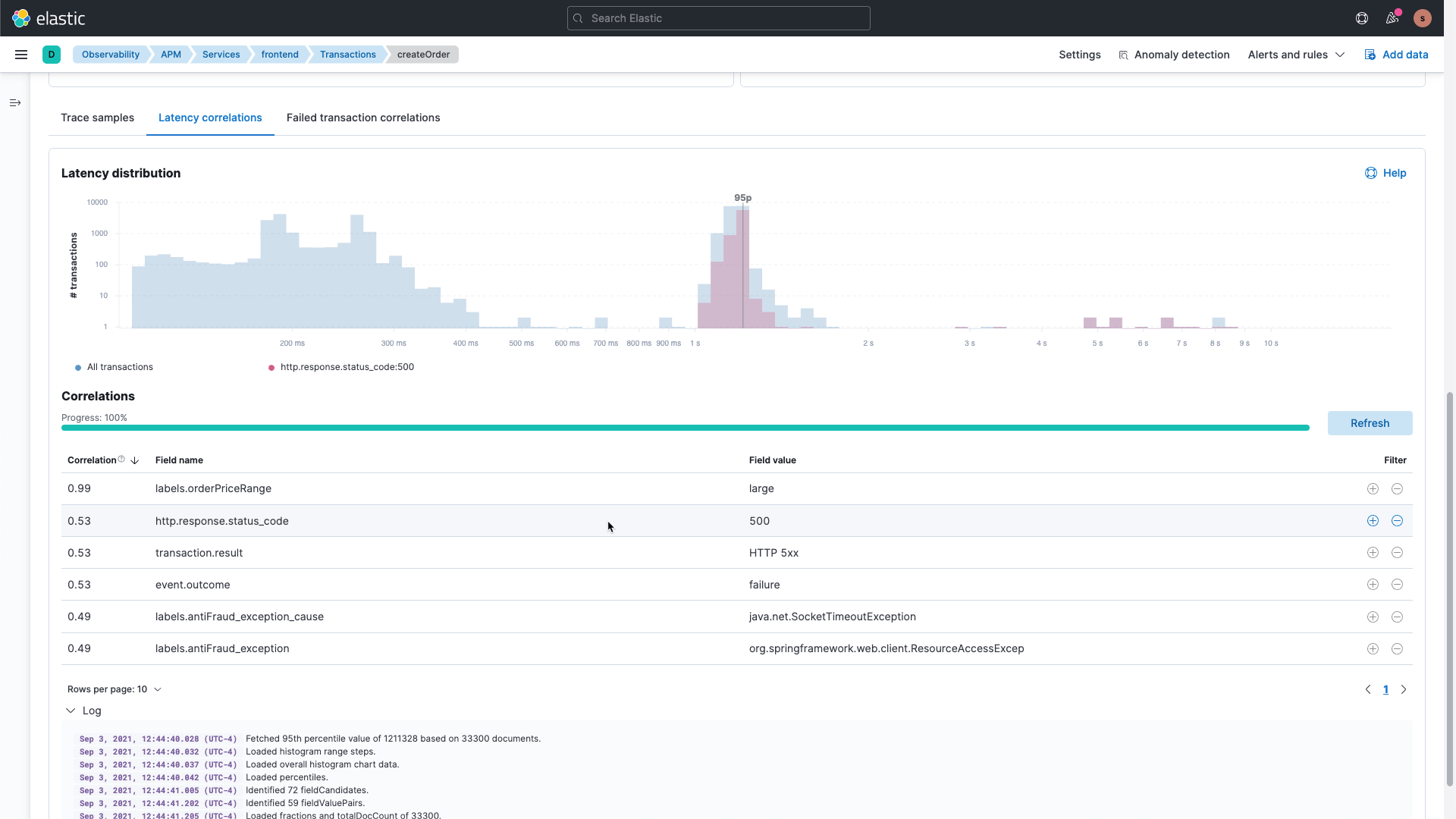

更智能的采样让问题无处可藏

灵活且可扩展的架构支持完全准确、100% 的事务样本捕获、存储、分析和搜索,并可根据需要进行设置,以扩大或缩小采样规模。通过对事务进行尾部采样,实现对采样条件更细粒度的控制,以获得最佳的可见性。

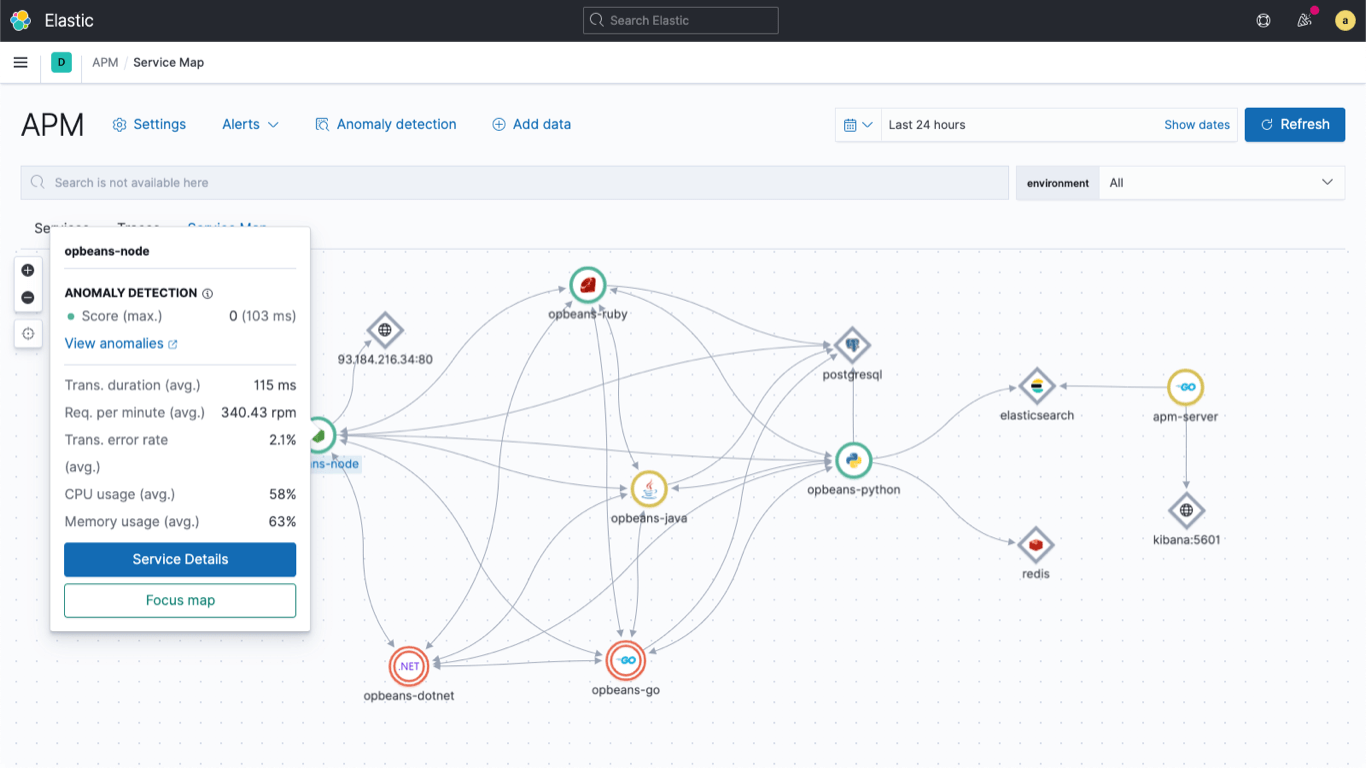

使用依赖关系映射快速查明应用程序问题

通过自动以精心设计的可视化来呈现所有依赖关系(包括云、消息传递、数据存储、LLM 和第三方服务及其性能数据),识别性能问题。深入研究异常值、事务详情和指标,以便进行更深入的分析。

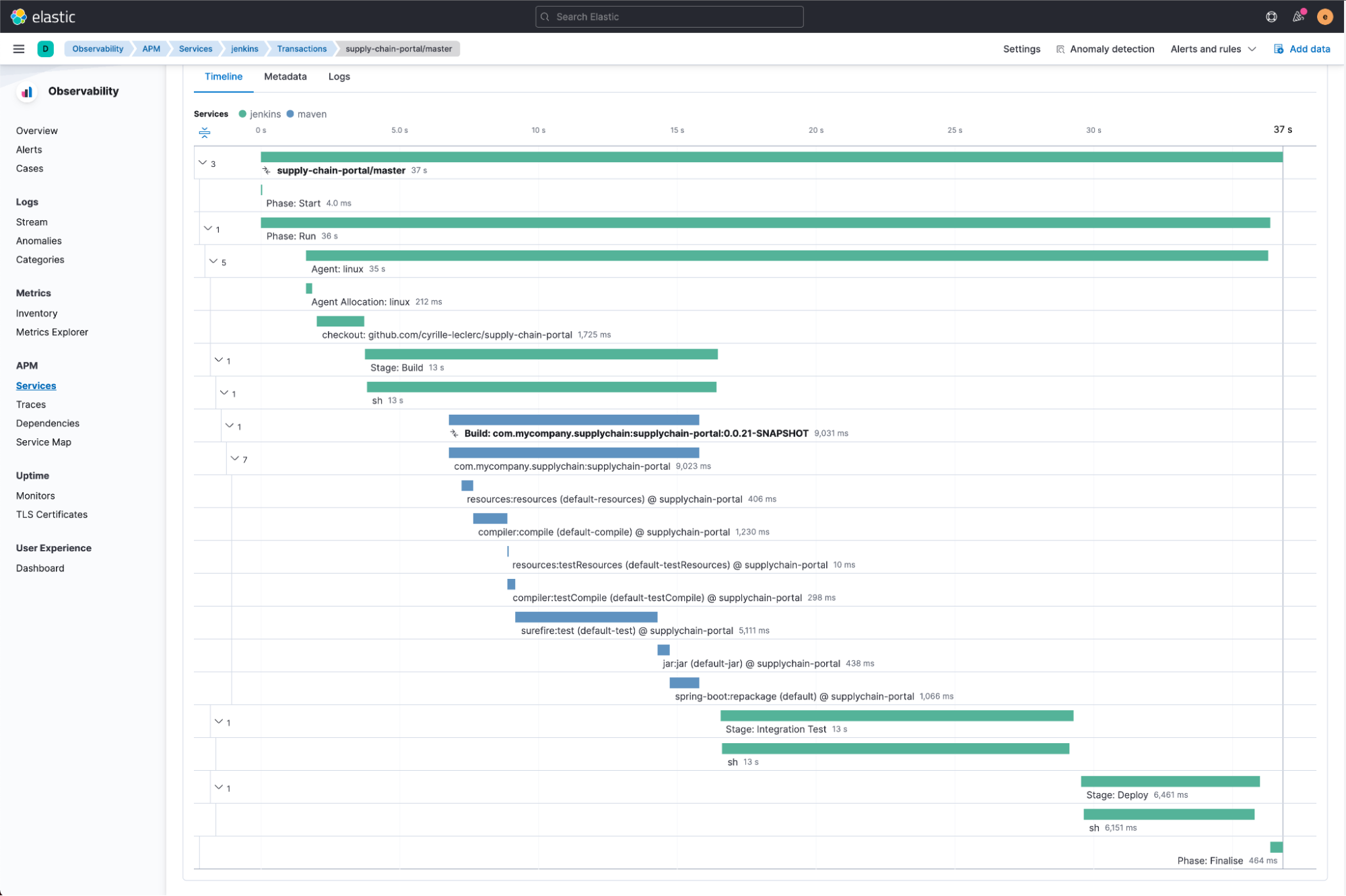

借助 CI/CD 管道可见性信心满满地进行部署

在新部署或“蓝色与绿色”部署期间,通过持续的可见性识别和量化应用程序的性能变化。通过访问有背景信息的跟踪、日志和指标,找到问题的根源,将范围缩小到发行版、版本或有问题的节点。通过 Elastic 面向 Jenkins、Maven 和 Ansible 提供的基于开放标准的 OpenTelemetry 插件,深入了解容易出错的工作、缓慢的构建和不稳定的测试。

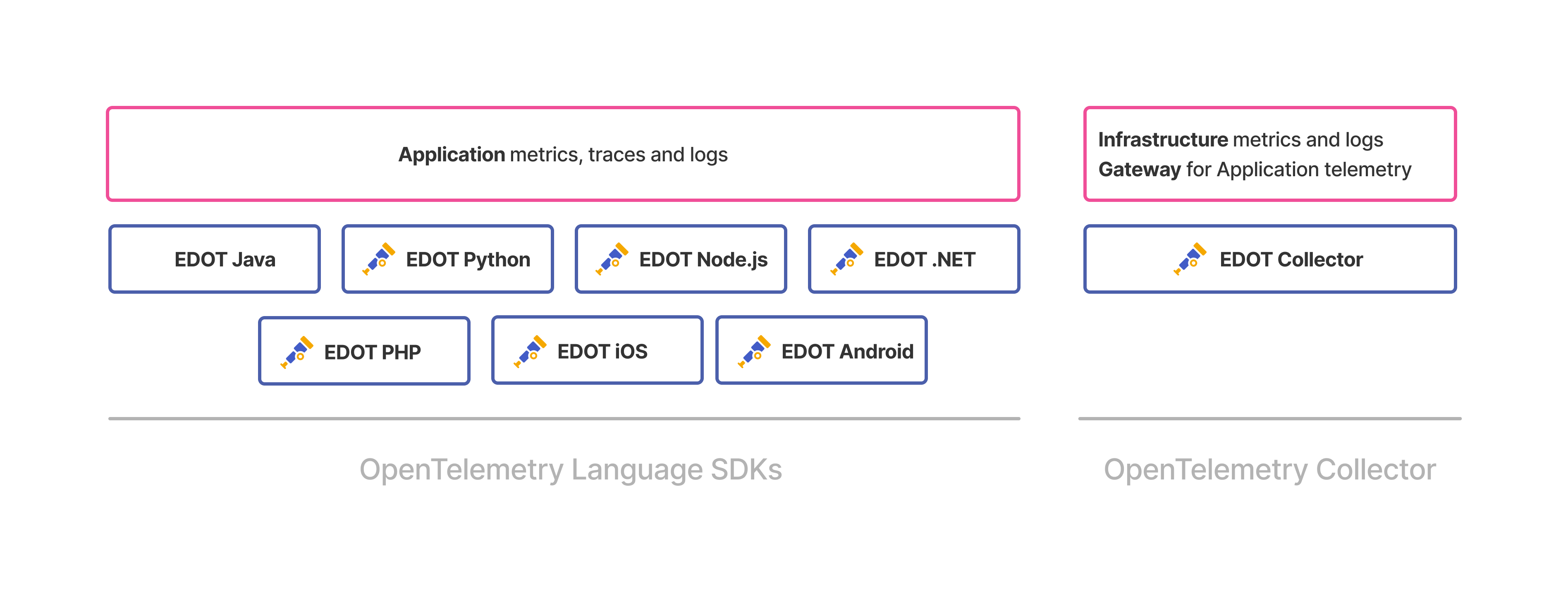

支持开放标准,造福开发人员

通过 OpenTelemetry 的 Elastic 发行版 (EDOT) 中包含的语言 SDK 启用 Java、.NET、Python、Node.js 和 PHP 应用程序的自动检测。对开放标准的支持还包括 W3C 跟踪上下文和 Jaeger,以及通过 EDOT 对 OpenAI(针对 Java、Python 和 Node.js)进行自动检测。第三方库(如 LangTrace、OpenLIT 和 OpenLLMetry)也可以与 OpenTelemetry 结合使用,以进行 LLM 跟踪。通过提供最大限度的灵活性和降低未来集成工作的成本,OpenTelemetry 和开放标准数据源可为您的可观测性投资提供未来保障。