尝试自定进度的实践学习,学习如何构建 RAG 应用程序。

尝试实践学习将 RAG 集成到您的应用程序中,并使用向量数据库尝试不同的 LLM。

在 Elasticsearch Labs 上了解更多信息了解如何使用 Elasticsearch Relevance Engine™ 构建基于 RAG 的高级应用程序。

观看快速入门视频获得《财富》500 强企业的信赖,推动生成式 AI 创新

让您的数据为 RAG 做好准备

RAG 通过访问相关专有数据而无需重新训练来扩展 LLM 的功能。将 RAG 与 Elastic 结合使用时,您可以获得以下好处:

- 最先进的搜索技术

- 轻松选择模型并能够轻松更换模型

- 通过安全文档和基于角色的访问控制,确保您的数据受到保护

转换搜索体验

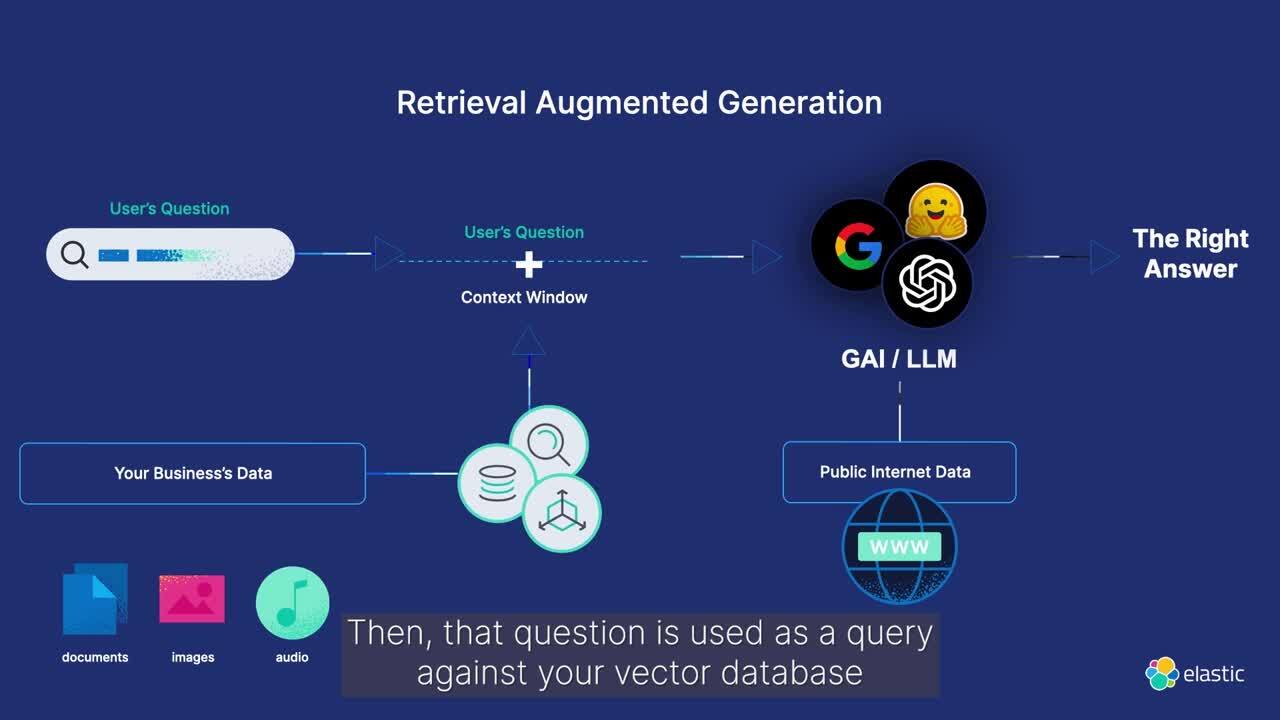

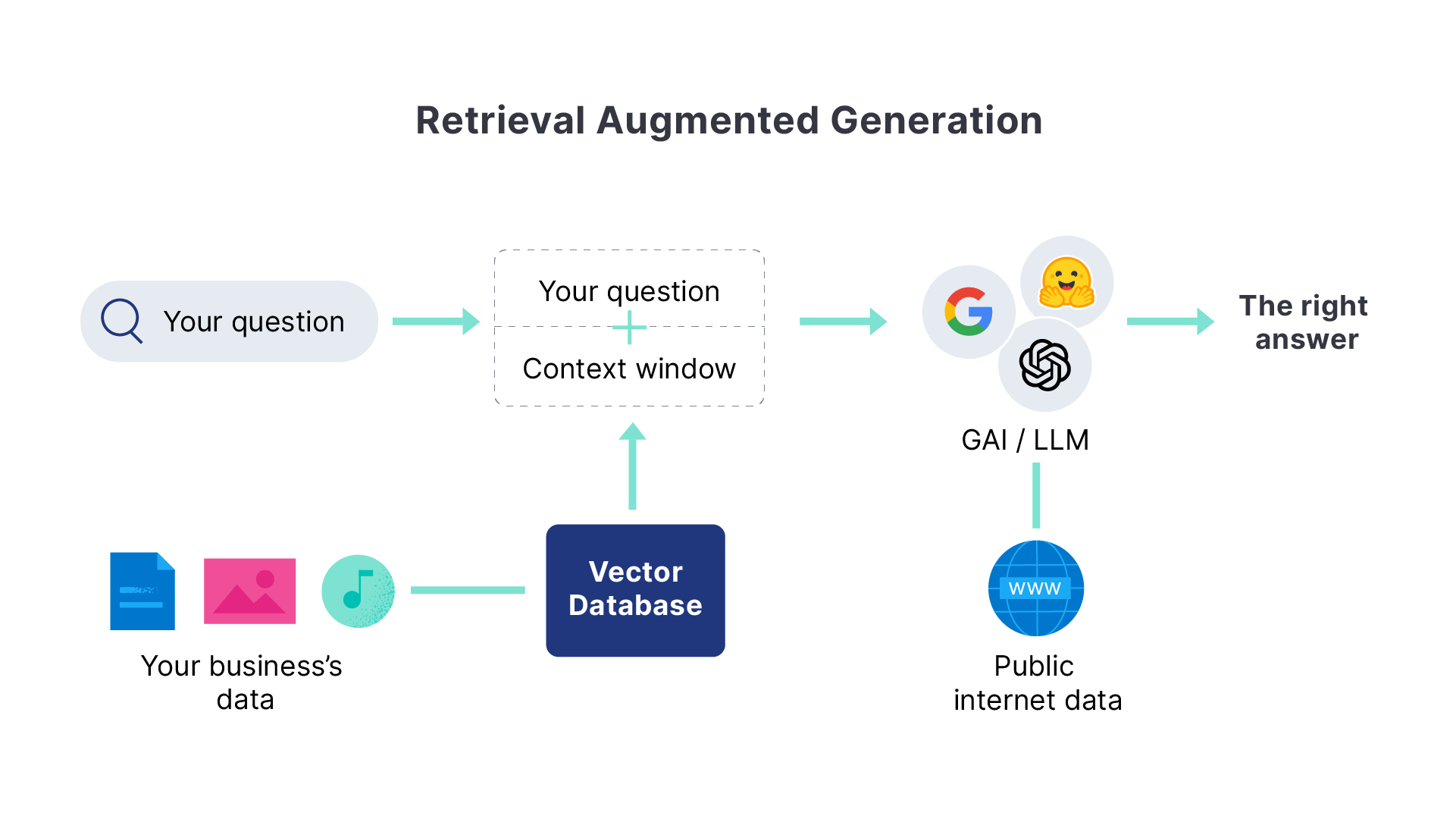

什么是检索增强生成?

检索增强生成(RAG)是一种通过整合专有数据源的相关信息来增强文本生成的模式。通过向生成模型提供特定领域的上下文,RAG 提高了生成文本响应的准确性和相关性。

使用 Elasticsearch 创建高相关性上下文窗口,利用您的专有数据来改进大型语言模型 (LLM) 输出,并以安全高效的对话式体验交付信息。

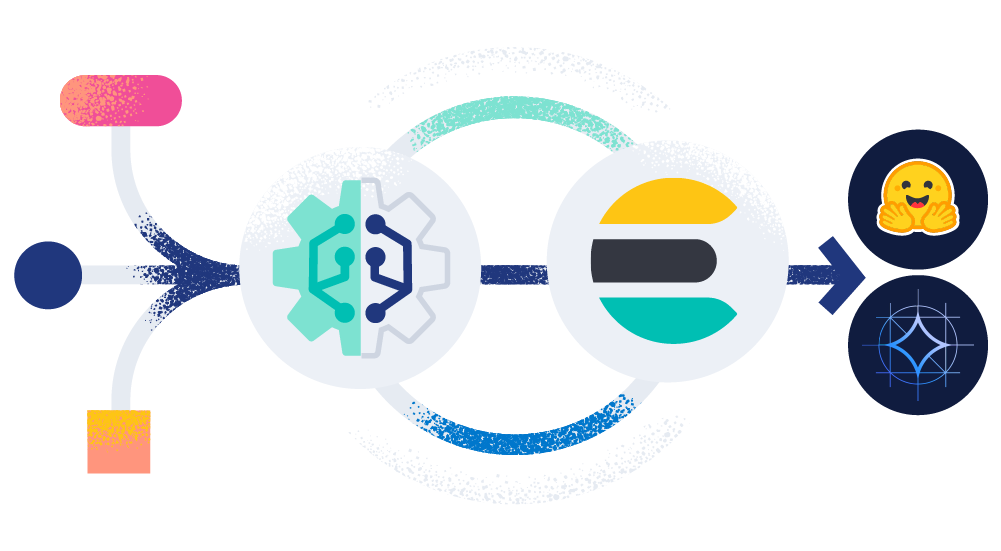

RAG 如何与 ELASTIC 协同工作

使用 Elasticsearch 增强 RAG 工作流

了解如何在 RAG 工作流中使用 Elastic 增强生成式 AI 体验。使用专有数据源轻松同步实时信息,以获得最佳、最相关的生成式 AI 响应。

机器学习推理管道使用 Elasticsearch 的摄取处理器来高效提取嵌入。它无缝地结合了文本(BM25 匹配)和向量(kNN)搜索,检索出得分最高的文档,以生成上下文感知的响应。

用例

在您的私有数据集上运行的问答服务

使用 RAG 实现问答体验,Elasticsearch 作为向量数据库提供支持。

AI 搜索 —— 实际应用

客户聚焦

Consensus 使用 Elastic 先进的语义搜索和 AI 工具升级了学术研究平台。

客户聚焦

Cisco 在 Google Cloud 上利用 Elastic 打造 AI 驱动的搜索体验。

客户聚焦

佐治亚州立大学利用 AI 驱动的搜索增强了获取数据见解的能力,并致力于探索如何帮助学生申请助学金。

常见问题

检索增强生成(通常称为 RAG)是一种自然语言处理模式,使企业能够搜索专有数据源并提供大型语言模型的基础背景信息。这使得在生成式 AI 应用程序中能够实现更准确和更实时的响应。

当最佳实施时,RAG 可以实时提供对相关的、特定领域的专有数据的安全访问。它可以减少生成式 AI 应用程序中幻觉的发生率,并提高响应的准确性。

RAG 是一种复杂的技术,依赖于:

- 输入数据的质量

- 搜索检索的有效性

- 数据安全

- 能够引用生成式 AI 响应的来源,以便对结果进行微调的能力

此外,在快速发展的生态系统中选择正确的生成式 AI 或大型语言模型 (LLM) 可能会给组织带来挑战。与 RAG 相关的成本、性能和可扩展性可能会阻碍企业将应用程序投入生产的速度。

Elasticsearch 是一个灵活的 AI 平台和向量数据库,能够索引和存储来自任何来源的结构化数据和非结构化数据。它为数十亿文档提供高效、可定制的信息检索和自动向量化功能。它还通过角色和文档级访问控制为企业安全提供保障。Elastic 还提供了一个标准接口,用于访问不断扩展的 GenAI 生态系统(包括超大规模计算平台、模型存储库和框架)中的创新。最后,Elastic 在生产规模环境中得到了验证,为超过 50% 的《财富》500 强公司提供服务。探索如何使用 Playground 在 Elastic 中构建 RAG 系统。

Elastic 提供跨集群搜索 (CCS) 和跨集群复制 (CCR),帮助您管理和保护私有、本地部署和云环境中的数据。通过 CCS 和 CCR,您可以:

- 确保高可用性

- 遵守全球数据保护法规

- 实现数据隐私和数据主权

- 制定有效的灾难恢复策略

Elastic 还提供基于角色和文档级的访问控制,授权客户和员工仅接收他们有权访问的数据的响应。我们的用户可以通过对任何部署的全面可观测性和监测获得见解。